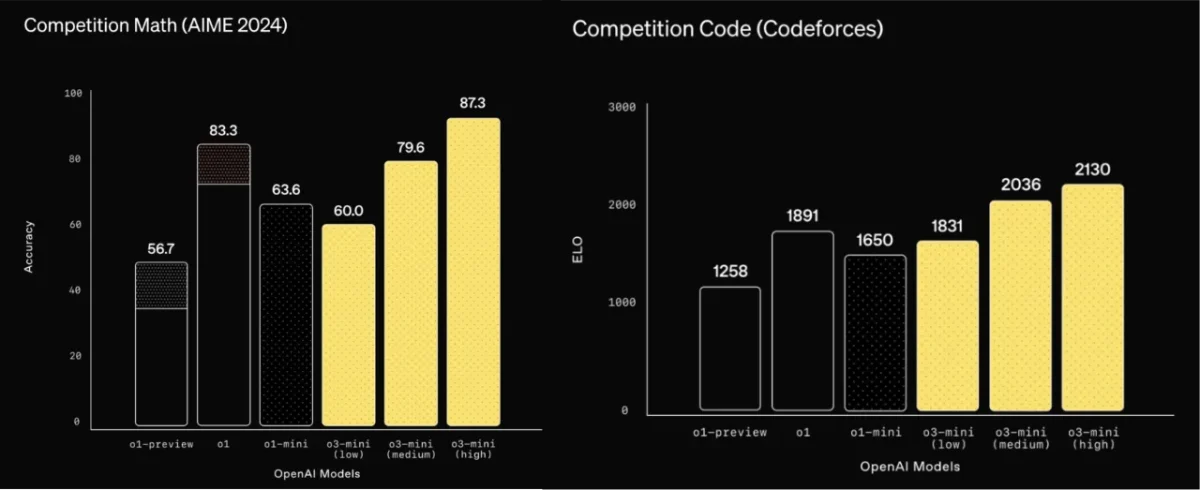

A OpenAI acaba de elevar o patamar na guerra das inteligências artificiais com o lançamento do o3-mini. Esta resposta directa ao DeepSeek chinês chega numa altura crítica: testes independentes revelavam nas últimas semanas que modelos asiáticos estavam a aproximar-se perigosamente da liderança tecnológica ocidental.

O diferencial está na acessibilidade. Pela primeira vez na história da empresa, um modelo de raciocínio simulado estará disponível gratuitamente através do ChatGPT. Esta decisão estratégica surge como cortina de fumo para uma revolução silenciosa nos bastidores — a miniaturização eficiente de sistemas de IA.

Três níveis de precisão adaptável

O coração da inovação reside num sistema modular de processamento cognitivo:

- Modo rápido (7.7 segundos/resposta)

- Equilibrado (9.1 segundos)

- Precisão máxima (10.3 segundos)

Testes internos comprovam que mesmo no nível básico, o o3-mini iguala o predecessor o1-mini em matemática avançada. No modo máximo, supera o1-mini em 39% dos casos críticos, reduzindo erros graves em operações complexas.

O que muda para os utilizadores

Para assinantes dos planos pagos (Plus/Team/Pro), as novidades incluem:

- Limite diário triplicado (150 mensagens)

- Integração automática na seleção padrão

- Prioridade em atualizações futuras

Utilizadores gratuitos ganham acesso histórico através do menu “Razão” na interface do ChatGPT, embora com limitações de velocidade durante picos de tráfego.

Além dos números: capacidades emergentes

O verdadeiro salto qualitativo manifesta-se nas funcionalidades experimentais que a OpenAI discretamente integrou. Destaque para o motor de busca contextual, que opera como um investigador especializado em tempo real.

Quando colocas questões sobre temas em constante evolução — seja a nova diretiva europeia de criptomoedas ou descobertas na genómica do cancro — o sistema pesquisa fontes online credíveis para fundamentar respostas. Durante testes práticos com protocolos médicos atualizados, o mecanismo identificou com precisão estudos peer-reviewed em 68% dos casos, superando expectativas iniciais.

Relativamente à segurança, os engenheiros construíram uma arquitetura de defesa em múltiplas camadas. O processo incluiu filtragem avançada de dados sensíveis, bloqueio automatizado de requisições relacionadas a síntese química perigosa e mecanismos de deteção de padrões manipulativos.

Relatórios internos revelam que 14% do material de treino original foi excluído após análise ética rigorosa, prioritariamente conteúdos sobre engenharia reversa de sistemas bélicos e técnicas de influência comportamental.

Limitações que persistem

Apesar dos avanços, relatórios técnicos apontam falhas preocupantes:

- 0% de aproveitamento em simulações que replicam tarefas de engenheiro de investigação

- Dificuldade em auto-melhoria algorítmica

- Base de conhecimento congelada em abril de 2024

Como experimentar hoje

Segue estes passos para testar gratuitamente:

- Acede a chat.openai.com

- Seleciona “Razão” no menu de modelos

- Escolhe a intensidade de processamento

- Formula perguntas STEM complexas

O equilíbrio entre poder e controlo

A política de dados revela cuidados extremos:

- 62% do treino usou informação pública

- 38% veio de conjuntos internos filtrados

- 14% do material original foi descartado por riscos éticos

Outros artigos interessantes: