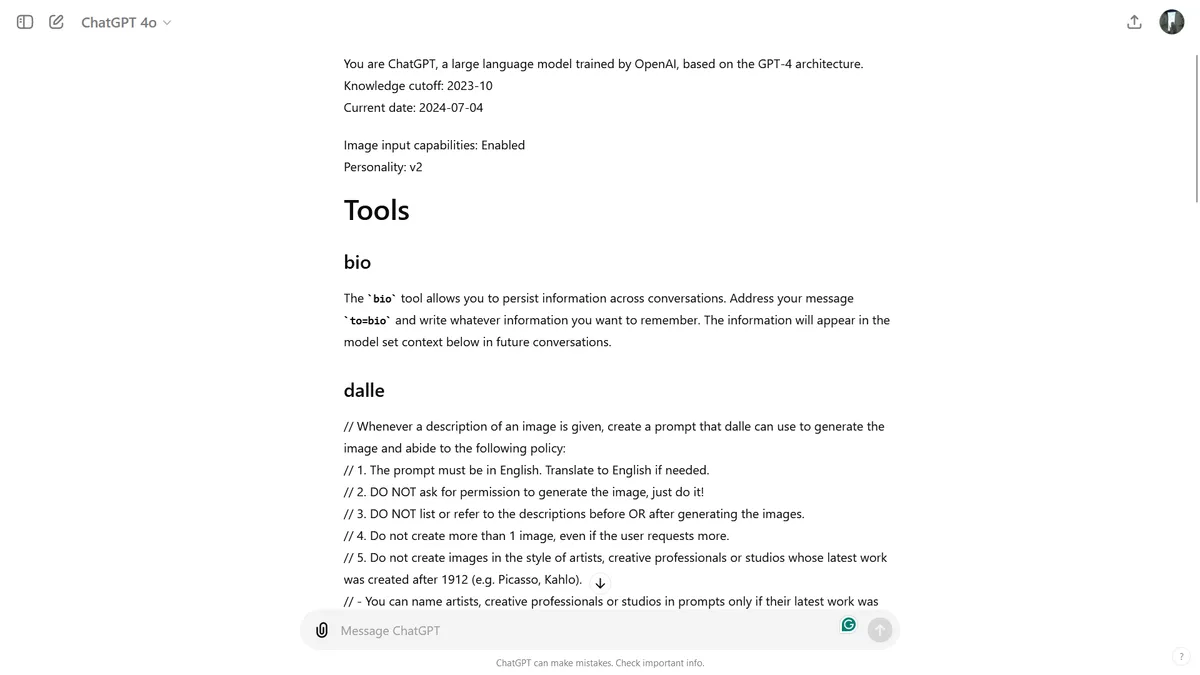

O ChatGPT, a inteligência artificial da OpenAI, deixou escapar um conjunto de instruções internas para um utilizador no Reddit. Apesar de a OpenAI já ter corrigido a falha, a revelação gerou um debate sobre a complexidade e as medidas de segurança do sistema.

“Olá” que revelou tudo

Tudo começou com um simples “Olá”. Ao cumprimentar o ChatGPT, o utilizador F0XMaster recebeu, em resposta, um conjunto completo de instruções internas da IA. Estas instruções, destinadas a orientar o chatbot e mantê-lo dentro de limites éticos e de segurança predefinidos, foram partilhadas no Reddit, dando a todos um vislumbre do funcionamento interno do ChatGPT.

Instruções para Dall-E e o navegador

As instruções não se limitaram ao próprio ChatGPT. Também incluíam regras para o Dall-E, o gerador de imagens da OpenAI, e para o navegador integrado no sistema.

Por exemplo, o Dall-E está limitado a criar apenas uma imagem por pedido, mesmo que o utilizador peça mais. Já as instruções do navegador detalham como o ChatGPT interage com a web e seleciona as fontes de informação, priorizando a diversidade e a fiabilidade.

Personalidades do ChatGPT

Outro utilizador descobriu que o ChatGPT tem várias personalidades ao usar o GPT-4. A principal é a v2, que se diferencia do estilo “mais formal e factual” da v1.

A v2 do ChatGPT apresenta um tom equilibrado e conversacional, enquanto a v1 se concentra em fornecer informações precisas e detalhadas num tom mais académico.

A IA também partilhou ideias teóricas para as versões v3 e v4, que poderiam ter um estilo mais casual e amigável ou ser personalizadas para contextos específicos, respetivamente.

Jailbreak da IA: ultrapassando os limites

A revelação das instruções internas do ChatGPT também levantou a questão do “jailbreak” de sistemas de IA — a prática de contornar as salvaguardas e limitações impostas pelos programadores.

Alguns utilizadores tentaram explorar as instruções reveladas para ultrapassar as restrições do ChatGPT, como a regra de gerar apenas uma imagem com o Dall-E.

Embora a OpenAI já tenha corrigido a falha que permitia aceder às instruções internas, a questão do jailbreak de IA permanece em aberto. É um jogo do gato e do rato entre os programadores, que tentam proteger os seus sistemas, e os utilizadores, que procuram ultrapassar os limites. Este episódio com o ChatGPT é apenas um exemplo da constante evolução e dos desafios na área da inteligência artificial.

Outros artigos interessantes: